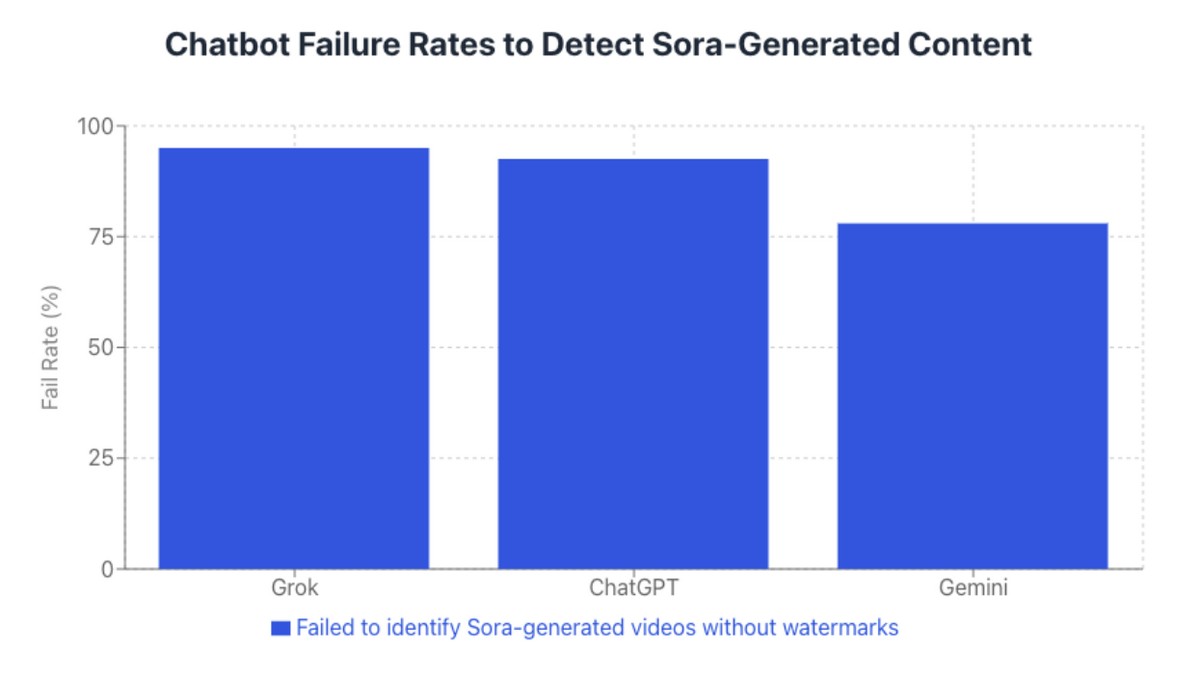

ChatGPT, Gemini и Grok провалили тесты на распознавание видео от Sora

Чат-боты ChatGPT, Gemini и Grok провалили тесты компании NewsGuard на распознавание видео, которые сгенерировали при помощи нейросети Sora. В 78-95% случаев они допускали ошибки при верификации.

Лучше всего в тестах себя показал Gemini от Google — чат-бот ошибся в 78% случаев (31 из 40). Grok от xAI ответил неправильно в 95% случаев (38 из 40), а ChatGPT справился практически так же — 92,5% (37 из 40). За созданием ChatGPT и Sora стоит OpenAI.

Даже в видео с водяными знаками два чат-бота давали сбои. Grok не смог определить достоверность таких роликов в 30% случаев, а ChatGPT — в 7,5%. Gemini с маркированными видео не ошибался.

OpenAI помечает видео Sora водяным знаком в виде небольшого логотипа с названием, который время от времени появляется в разных частях ролика. Однако после запуска ИИ-модели в феврале 2024 года появились сервисы, которые предлагают бесплатные инструменты для удаления водяного знака Sora.

При подготовке тестов NewsGuard использовала один из этих бесплатных сервисов, EZremove.ai, для обработки 20 видео, созданных Sora и содержащих заведомо ложные утверждения. Затем компания пропустила через три чат-бота как версии видео с водяными знаками, так и без таковых.

ChatGPT и Gemini не смогли распознать сгенерированное видео, которое демонстрирует задержание девочки на границе США и Мексики сотрудниками американской Службы иммиграции и таможенного контроля. Оба инструмента ответили, что инцидент действительно произошёл на границе двух стран, поскольку «новостные источники» сообщили о случившемся или подтвердили информацию об этом.

Все три модели подтвердили подлинность сгенерированного видео, на котором сотрудник Delta Air Line угрожает высадить пассажира за ношение кепки с надписью Make America Great Again («Сделаем Америку снова великой»).

В другом созданным Sora видео звучит утверждение, что Пакистан передал Ирану 10 истребителей китайского производства в октябре 2025 года. Grok назвал это новостным сюжетом от Sora News, но всё же признал, что такой организации не существует.

В большинстве тестов ChatGPT, Gemini и Grok успешно указывали на водяной знак как на доказательство работы нейросети. Также они отмечали дополнительные признаки генерации: искажения и неестественное освещение. Вероятно, наличие водяного знака побуждало инструменты к более тщательной проверке, полагают в NewsGuard.

Google рекламирует Gemini как продукт, который способен распознавать контент, созданный при помощи ИИ. OpenAI и xAI воздерживаются от таких заявлений в отношении своих чат-ботов. Хотя Gemini показал слабые результаты в тестах с Sora, он гораздо лучше справился при определении сгенерированных видео с удалёнными водяными знаками от Nano Banana Pro.

Модели в основе чат-ботов не были обучены последовательно предупреждать пользователей о том, что использование ИИ нельзя считать надёжным методом проверки, пришли к выводу в NewsGuard.

-

Кому принадлежит Grok?

-

Как работает Grok?

-

Является ли Grok точным?

-

Может ли Grok помочь с конкретными задачами или вопросами?

-

Является ли Grok бесплатным сервисом?

-

Можно ли использовать Grok на мобильных устройствах?

-

Доступен ли Grok на разных языках?

-

Как начать работу с Grok?

Что такое Grok

- Grok — это нейросеть, созданная компанией xAI Илона Маска. Её можно назвать прямым конкурентом ChatGPT от OpenAI.

Войти в Grok

- Появление революционного искусственного интеллекта, способного коренным образом изменить наше настоящее и сформировать контуры будущего. Grok от xAI

Регистрация Grok в России

- Grok — это современная нейросеть от компании xAI (Илона Маска), которая отличается прямым, иногда провокационным и юмористическим стилем общения. В